Commentaire 500+ canapé 3D NAND est changeant la densité et la scalabilité

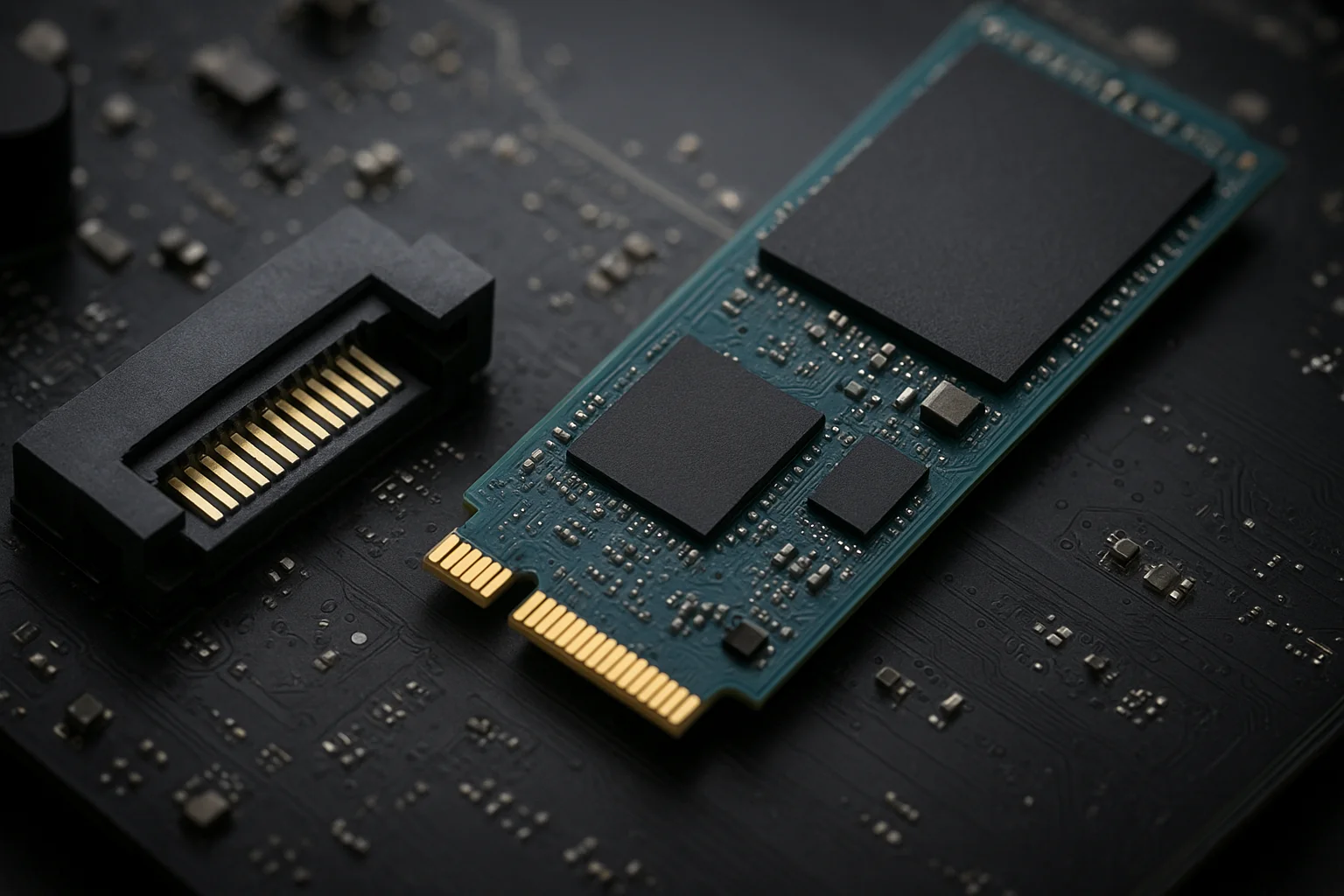

Aller à 500 canapés et plus dans 3D NAND représente un bond important dans l'échelle verticale par rapport aux générations précédentes (128, 256, 512 couches logiques, selon le nom du fournisseur). L'effet le plus immédiat est la densité brute des bits: empiler beaucoup plus de couches sur la même empreinte multiplie la capacité sans nécessiter une lithographie plus petite. Pour les concepteurs SSD et les intégrateurs de système, cela signifie des disques de plus grande capacité dans les mêmes facteurs de forme M.2, U.2 ou PCIe et un coût par gigaoctet plus faible au fil du temps.

Pratiquement, ce changement affecte la planification et l'inventaire des produits: les fabricants peu frire des UGS de plus grande capacité sans remodeler les contrôles ou les PCB. Pour les centres de données, les puces plus denses permettent de produire le nombre de disques par cible de capacité utilisable, ce qui peut produire l'espace de rack, le tirage de puissance par gigaoctet et les exigences de refroidissement lorsqu'elles sont optimisées correctement. Cependent, une densité plus élevée amplifie également les variations dans l'isolement des rapports et des défauts, de sorte que les équipes de produits doivent planifier pour une gestion plus forte des erreurs et des capacités inutilisées dans le firmware.

Impact sur le SSD Performance: Vitesse, Ladence et Endurance

Le rendement des canapés supérieurs n'est pas automatique égal à des performances brutes plus rapides. En fait, empiler plus de canapés augmentés globalement les longues de chaîne interne et la complexité du mouvement de charge, qui peuvent changer la programmation et les latences de lecture. Cela dit, les contrôleurs modernes et les architectures de canaux atténuent une grande partie de ce phénomène par le bis d'un parallèle avancé, d'un CEC plus puissant et d'algorithmes firmware améliorés.

Principales associations de rendez-vous à prendre en compte de l'adoption de la couche NAND 500+:

- Parallélisme au niveau des canaux et des matrices - utilisez plusieurs canaux et entrelacez pour cacher la latence par jour.

- Une CCE plus forte et un traitement des significatifs - planifier une augmentation des frais généraux et des augmentations potentielles du temps de décodage des CCE.

- Écrire l'amplification et le registre de la collection des ordures - les piles plus profondes peuvent affecter les modèles d'érosion des blocs; le firmware doit adapter les cycles d'effacement et les stratégies de placement.

Actions concrètes pour les ingénieurs: le candidat de référence NAND sous des profils de charge de travail mixte (petits E/S aléatoires, grandes écritures séquentielles, charge de travail élevée en écriture) et collecte des mesures sur le débit, IOPS et 99e percentile latence. Tune firmware suisse GC et sur-fourniture pour équilibrer l'endurance par rapport à la capacité utilisable.

Défis de fabrication derrière NAND ultra-haute couche

La production de plus de 500 canapés crée une grande complexité du processus. L'uniformité verticale, le contrôle des dépôts et l'alignement sur des centaines de canapés repoussent les limites des outils de fabrication actuels. Les principaux défi sont les suivants:

- - Rapport d'aspect de l'etch: création de grands groupes est à travers des centaines de canapés sans rupture ni variation.

- - Contrôle des défauts de canadiens à canadiens: un défaut dans une couche peut affecter de nombres cellulaires; la gestion du rendez-vous plus granulaire.

- - Métrologie et inspection: de nouvelles études d'inspection et de métrologie en ligne sont nécessaires pour protéger les variations des sous-nomètres sur de nombreuses couches.

Du point de vue de la chaîne d'approvisionnement, s'attendre à ce que les expéditions initiales soient limitées et à un prix plus élevé jusqu'à ce que les rendus s'améliorent. Pour les gestionnaires de produits, une stratégie d'atténuation pratique consiste à qualifier les appareils qui proviennent de fondations ou de fabs multiples lorsque cela est possible, et à construire des BOM flexibles qui permettent des ajustements UGS à mesurer que les rendus et les prix évolutifs.

Efficacité énergétique et comportement thermique dans les SSD du prochain génération

Denser NAND peut améliorer l'efficacité énergétique par bit stocké, mais il est également la production de chaleur. Les cycles de programme/effacement et les opérations de lecture produisent des points chauds thermiques au niveau des matrices qui, s'ils ne sont pas gérés, peuvent accélérer la force de rétention ou augmenter les niveaux d'erreur. Les concepts de systèmes doivent donner:

- Mesurer la réponse thermique au niveau de l'investissement en fonction de la charge de travail réelle et identifier tous les points de blocage ou de conflit.

- Réglez les politiques de grottling thermique dans le firmware pour inviter des banques de performance brutales tout en protégeant l'endurance.

- Refroidissement de conception au niveau du système (récepteurs de chaleur, débit d'air, emplacement du châssis) pour des charges de travail élevées plutôt que des éclatements de pointe seulement.

Exemple de meilleure pratique: implémenter des modes de puissance dynamique dans le firmware qui justifie le cours de programme de pointe pendant les écrits souverains tout en augmentant le parallélisme dans les périodes de repos pour récupérer le débit. En outre, surveillez les mesures thérapeutiques SMART pour concevoir les décisions de placement côté hôtel (par exemple, inviter de placer des VMs en écriture sur des disques déjà chauds).

Cas d'utilisation futurs pour les consommateurs et les entreprises actives par 500 canapés+

Une plus grande capacité par disque permet de dégager des avantages concrets sur tous les marchés. Pour les consommateurs, assistant des lecteurs NVMe haute capacité pour le jeu et la création de contenu à des points de prix plus abordables, permettant des postes de travail mono-drive qui ont déjà exigé des configurations multi-drive. Pour les entreprises et les fournisseurs de cloud, la densité diminue le nombre d'investissements nécessaires pour un niveau de capacité donné, ce qui simplifie la maintenance et rend la complexité du rack.

Scénarios pratiques de déploiement et recommandations:

- - Serveurs de contenu et de médias: utiliser des lecteurs à plus grande capacité pour consolider les ensembles de données et faire les dépenses du réseau.

- - Calcul des bords: grande capacité, petit facteur de forme Les SSD simplifient le déploiement sur des sites éloignés où l'espace physique est limité.

- - Stock Échelonné: paire de SSD NAND ultra-dense en tant que niveaux proches de la ligne pour les données chaudes, tout en conservant les données les plus chaudes sur les supports haute résistance ou les canapés de cache.

Lors de la planification des migrations ou des cycles de rafraîchissement, les opérateurs doivent exécuter des modèles de capacité par rapport aux modèles de performance plutôt que de supposer que la densité est plus rapide. Inclure le budget d'endurance (drive écrit par jour), les temps de reconstruction et l'impact sur la performance de ces modèles. Enfin, gardez un œil sur les chemins de mise à jour du firmware: à mesurer que les appareils de 500 canapés séront matures, les fournisseurs publiés des mises à jour de contrôle/firmware qui affectent le matériel de l'endurance et les performances réelles – avoir un processus de mise à jour du firmware en doux est essentiel.

Synopsis comparatif: générations anciennes vs 500+ canapés

On trouve ci-dessous un tableau concis correspondant aux répercussion pratiques au niveau de l'appareil sur les jalons représentatifs afin d'aider les équipes à prendre des décisions tactiles. Utilisez-le comme référence rapide lors de la sélection des UGS ou des mises à niveau à niveau de la capacité de planification.

| Caractéristiques | ~128-256 Calque | ~500+ Calques |

|---|---|---|

| Capacité typique par jour | Faible à moyen | Haut |

| Pouvoir par GB stocké | Supérieur | Inférieur (mais les points thermiques de pointe) |

| Risque de retraitement de fabrication | Souris | Plus l'initialisation |

| complexité du micrologiciel | Modéré | Plus Élevé (plus de CPE et de gestion) |

| Cas d'utilisation optimale | Capacité modérée et sensée aux performances | Consolidation à haute capacité, quasi-ligne, consommation à forte capacité |